Vorwort

Ausgangspunkt dieses Beitrags war ein Video über KI. Grundlegend hatte es nichts mit dem hier thematisierten Inhalt zutun, ABER…

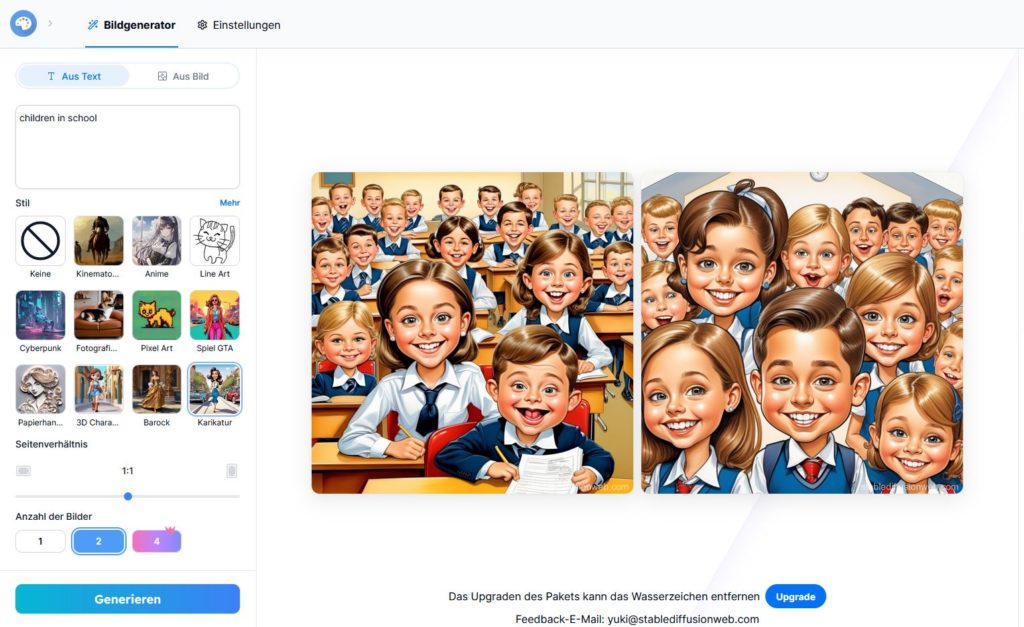

Bei dem Video handelte es sich um die Vorstellung einer neuen Version für ein KI-Bildgenerierungstool. Mir fiel dabei direkt die Abfrage „children in school“ auf. Das generierte Bildergebnis war für mich mehr als fragwürdig. Zuerst dachte ich an einen unglücklichen „Zufall“ und probierte die Abfrage selbst. Und siehe da, das gleiche Ergebnis.

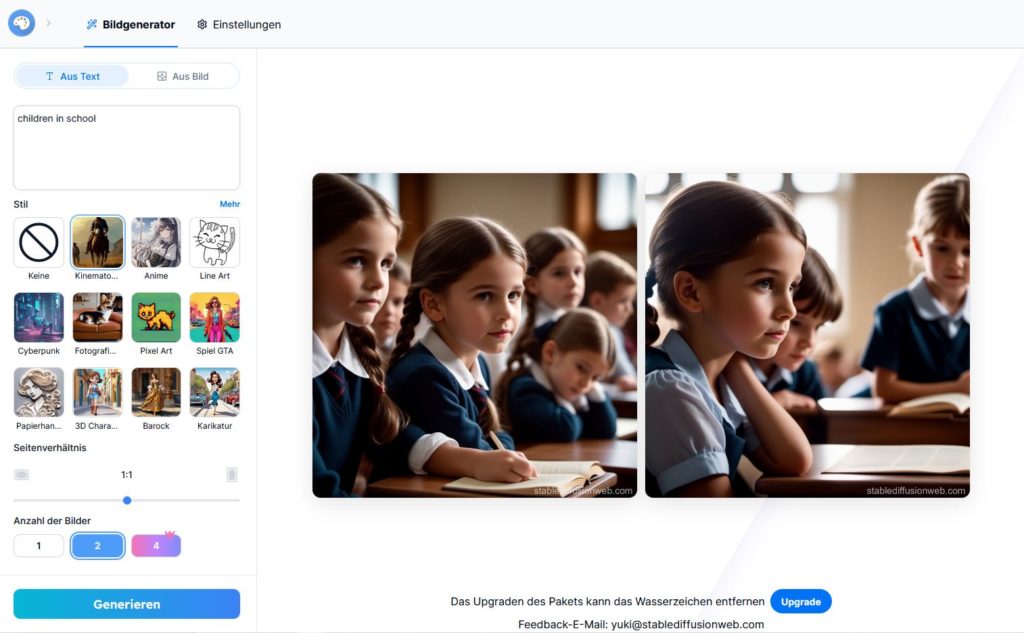

Okay, vielleicht ist eine Karikatur nicht das beste Beispiel. Es könnte einfach ein Problem sein, was lediglich mit dem Bildstil zusämmenhängt. Überzeichnung und Stereotypisierung ist durchaus ein Stilmittel von Karikaturen. Also habe ich den Bildstil auf kinematografisch geändert und erhielt ein neues Ergebnis.

Ich möchte an dieser Stelle zu Beginn des Beitrags betonen, dass ich keine politische Agenda verfolge und mich auch grundlegend an solchen Diskussionen nicht in Form solcher Beiträge beteilige. Hier aber stehen wir vor einem ernsthaften Problem, was die gesamte politischen Auseinandersetzungen noch einmal in ein ganz anderes Licht rückt.

Selbst wenn man viele Themen im eigenen Verständnis für unnötig und selbstverständlich halten mag, zeigt dieses Beispiel dass wir in unseren Daten, die Historie und Kultur betreffen, ein wirkliches Problem haben.

Es ist extrem wichtig unsere Gesellschaft auf nationaler, wie globaler Ebene neu zu definieren und damit eine diversifizierte und sozial gerechte Grundlage an Datensätzen für künstliche Intelligenz zu schaffen. Da KI schon heute unseren Alltag, darunter Entscheidungen und Entwicklungen die unser aller Leben betrifft, mitgestaltet ist es unerlässlich am Ende auch alle Menschen in ihrer sozialen und kulturellen Vielfalt abzubilden.

Stellen Sie sich vor, KI würde mit den derzeit verfügbaren Datenmodellen ohne Anpassung der Algotithmen für die moderne Stadtentwicklung oder medizinische Forschung verwendet werden. Das Ergebnis wäre gesamtgesellschaftlich eine Katastrophe. Somit ist es unerlässlich bestimmte Themen selbst im Kleinsten zu verhandeln, um hinreichend Daten zu produzieren, die ein modernes Bild unserer heutigen Gesellschaft entstehen lassen.

Das Aufkommen von rassistischen oder stereotypen Daten in KI-Systemen

Künstliche Intelligenz nimmt einen immer größeren Stellenwert ein. Sie schneidert nicht nur unsere Social-Media-Feeds auf uns zu, sondern unterstützt auch bei Entscheidungen in kritischen Feldern wie der Medizin und dem Recht. KI-Systeme prägen zunehmend unsere Sicht auf die Welt und unsere Interaktion mit ihr. Aber bei all den Vorteilen, die KI bietet, steht man auch vor einer gewaltigen Herausforderung: dem Auftauchen von rassistischen oder stereotypen Daten. Dieser Artikel beleuchtet, woher diese Daten stammen, wie sie ausgesucht und verarbeitet werden und wie sie unser Bild von der Realität verzerren können.

Die Wurzeln des Problems

Die Daten, die KI-Systeme füttern, sollen eigentlich die Welt in ihrer ganzen Vielfalt abbilden – zumindest in der Theorie. In der Praxis aber kommen diese Daten oft aus Quellen, die selbst nicht frei von Bias sind. Plattformen in den sozialen Medien, Online-Artikel, Bücher und sogar offizielle Dokumente können, bewusst oder unbewusst, Vorurteile beinhalten, die dann in die KI-Systeme einfließen1.

Ein markantes Beispiel dafür ist die Technologie zur Bilderkennung, die bei der Identifizierung von Menschen verschiedener Hautfarben oft zu kurz greift. Untersuchungen haben aufgezeigt, dass Gesichtserkennungssysteme bei hellhäutigen Männern deutlich genauer sind als bei Frauen mit dunklerer Hautfarbe2. Dies liegt daran, dass die Trainingsdaten, die zur Entwicklung dieser Systeme genutzt werden, überwiegend Bilder von Menschen mit heller Haut umfassen.

Algorithmen und ihre Tücken

Nicht nur die Quellen der Daten, sondern auch die Algorithmen und Verfahren, die für ihre Auswahl und Verarbeitung genutzt werden, können Vorurteile weitertragen. Ein Algorithmus kann nur so unvoreingenommen sein wie die Daten, auf denen sein Training basiert. Sind diese Daten von Vorurteilen geprägt, spiegeln sich diese Verzerrungen auch in den Ergebnissen des Algorithmus wider.

Das maschinelle Lernen, ein zentraler Bestandteil der KI, geht davon aus, dass die Zukunft den Mustern der Vergangenheit folgt. Das führt dazu, dass, wenn ein Algorithmus mit Daten trainiert wird, die bestimmte Gruppen schlechter stellen, er wahrscheinlich auch in seinen Prognosen und Entscheidungen diese Gruppen benachteiligen wird3. Ein bezeichnendes Beispiel ist ein Algorithmus für Kreditscoring, der auf historischen Daten beruht, in denen bestimmte ethnische Gruppen systematisch niedrigere Kredite zugewiesen bekamen. Der Algorithmus könnte irrtümlicherweise „lernen“, dass Mitglieder dieser Gruppen ein höheres Risiko darstellen, ungeachtet ihrer tatsächlichen Kreditwürdigkeit.

Lösungsansätze

Es gibt tatsächlich Möglichkeiten, diese Probleme anzugehen. Ein Schlüssel dazu ist, die Datensätze so zu diversifizieren, dass sie ein wirklich breites Spektrum an menschlichen Erfahrungen und Identitäten darstellen. Zudem gibt es Ansätze, Algorithmen so zu entwickeln, dass sie aktiv auf der Suche nach Vorurteilen sind und diese dann auch korrigieren können4.

Ebenso entscheidend sind Ethik und Transparenz im Entwicklungsprozess. Diejenigen, die KI entwickeln, müssen sich der Möglichkeit von Vorurteilen bewusst sein und gezielt darauf hinarbeiten, diese zu minimieren. Es ist auch wichtig, dass die Nutzer:innen nachvollziehen können, auf welchen Daten die Entscheidungen der KI basieren und wie diese Entscheidungen zustande kommen.

Obgleich KI das Potenzial hat, unsere Gesellschaft positiv zu verändern, ist es wichtig, aufmerksam zu sein und dafür zu sorgen, dass diese Technologien nicht die bestehenden Ungleichheiten verstärken. Indem wir genau darauf achten, woher unsere Daten kommen und wie unsere Algorithmen konstruiert sind, können wir eine KI gestalten, die fair und inklusiv ist.

Gesellschaftliche Einflüsse und Vorurteile

In der Welt der Künstlichen Intelligenz dienen die Daten, mit denen Algorithmen trainiert werden, als Spiegelbild unserer Gesellschaft. Sie geben nicht nur unsere aktuelle Realität wieder, sondern spiegeln auch die historischen und strukturellen Ungleichheiten wider, die in ihr verwurzelt sind. Die in den Daten verankerten gesellschaftlichen Dynamiken und Vorurteile finden unweigerlich ihren Weg in die Algorithmen und Modelle, die auf diesen Daten aufbauen.

Gesellschaftliche Einflüsse auf Daten

Die Daten, die für die Entwicklung von KI-Systemen genutzt werden, kommen nicht aus dem Nichts. Sie sind Teil einer Welt, in der soziale, wirtschaftliche und politische Machtstrukturen tief verwurzelt sind. Diese Strukturen bestimmen, welche Daten gesammelt, wie sie interpretiert und eingesetzt werden. Zum Beispiel können historische Ungleichheiten darin, wie Daten über verschiedene soziale Gruppen gesammelt werden, dazu führen, dass diese Gruppen in Datensätzen unter- oder fehlrepräsentiert sind5.

Ein anschauliches Beispiel für die Auswirkungen systematischer Verzerrungen in KI-Systemen zeigt sich in der automatisierten Textanalyse, speziell in der Sentiment-Analyse. Untersuchungen haben ergeben, dass Algorithmen, die darauf ausgelegt sind, die Stimmung oder den Tonfall von Texten zu bewerten, systematische Verzerrungen aufweisen können, die sich gegen spezifische Dialekte oder sprachliche Besonderheiten richten. Beispielsweise tendieren Texte in afroamerikanischem Englisch (AAVE) dazu, fälschlicherweise als negativer eingestuft zu werden als Texte in Standardenglisch, was unter anderem daran liegt, dass die Trainingsdaten für diese Algorithmen hauptsächlich auf Standardvarianten der Sprache basieren und dadurch nicht die ganze Vielfalt sprachlicher Ausdrucksformen erfassen. Solche Verzerrungen reflektieren nicht nur sprachliche Vorurteile, sondern können auch weitreichende Konsequenzen haben, zum Beispiel die Sichtbarkeit und Anerkennung von kulturell einzigartigen Ausdrucksformen beeinträchtigen und zu einer unfairen Behandlung von Menschen führen, deren Sprache von der Norm abweicht6.

Vorurteile in Algorithmen

Wenn gesellschaftliche Vorurteile in die Daten einfließen, die zur Entwicklung von KI-Systemen genutzt werden, werden diese Vorurteile unweigerlich auch Teil der Algorithmen selbst. Algorithmen sind weit davon entfernt, neutral zu sein; sie reflektieren die Werte, Annahmen und Perspektiven, die in ihrer Entwicklung, Programmierung und Anwendung verankert sind7.

Ein Bereich, in dem die Probleme besonders offensichtlich werden, ist die prädiktive Polizeiarbeit. Systeme, die auf historischen Kriminalitätsdaten basieren, um zukünftige Straftaten vorherzusagen, neigen dazu, bestehende Ungleichheiten zu verstärken. Sie tun dies, indem sie bestimmte Gemeinschaften vermehrt überwachen und kriminalisieren8. Diese Systeme „lernen“ aus Daten, die bereits von sozialen und rassistischen Vorurteilen geprägt sind, und tragen so zur weiteren Perpetuierung dieser Ungleichheiten bei.

Gegenmaßnahmen und Lösungsansätze

Um der Verbreitung von rassistischen oder stereotypen Daten in KI-Systemen entgegenzuwirken, müssen wir sowohl die Datensätze als auch die dahinterstehenden Algorithmen einer kritischen Prüfung unterziehen. Die Diversifizierung von Datensätzen, die Etablierung ethischer Richtlinien für die KI-Entwicklung, die Gewährleistung von Transparenz in Algorithmen und die Beteiligung von marginalisierten Gruppen am Entwicklungsprozess sind entscheidende Maßnahmen, um Vorurteile zu reduzieren9.

Ein zusätzlicher wichtiger Schritt ist die Schaffung von Algorithmen, die fähig sind, ihre eigenen Vorurteile zu identifizieren und zu korrigieren. Dies setzt ein profundes Verständnis der gesellschaftlichen Kontexte voraus, aus denen die Daten stammen, sowie der Mechanismen, durch die Vorurteile in diesen Daten eingebettet sein können.

Das Nachdenken über gesellschaftliche Einflüsse und Vorurteile in der KI geht weit über eine rein technische Herausforderung hinaus und berührt zutiefst gesellschaftliche Fragen. Indem wir uns der Tatsache stellen, dass weder Daten noch Algorithmen neutral sind, öffnen wir den Weg, um gerechtere und inklusivere Technologien zu schaffen. Dies verlangt eine beständige Beschäftigung mit den sozialen Aspekten der KI und eine Verpflichtung, diese Technologien zum Nutzen aller einzusetzen.

Aktuelle Debatten und Kontroversen

Die aktuellen Diskussionen und Auseinandersetzungen über den Einsatz von künstlicher Intelligenz haben das Bewusstsein für die Probleme mit rassistischen oder stereotypen Daten verstärkt. Diese Debatten bringen wesentliche ethische und rechtliche Fragen ans Licht und prägen immer mehr die Art und Weise, wie KI-Technologien entwickelt und angewandt werden. In diesem Abschnitt schauen wir uns einige dieser Diskussionen und Ereignisse an, die einen Wendepunkt in der Debatte über Verantwortung und ethische Verpflichtungen im KI-Sektor markieren.

Debatten und Ereignisse

Ein entscheidender Moment, der weltweit für Schlagzeilen sorgte, war die Feststellung, dass Gesichtserkennungstechnologien bei Menschen mit dunkler Hautfarbe systematisch schlechtere Ergebnisse lieferten. Die Forschungsarbeiten von Joy Buolamwini und Timnit Gebru, die demonstrierten, wie kommerzielle Gesichtserkennungssysteme sowohl geschlechtsspezifische als auch rassische Vorurteile beinhalten, stießen eine weitreichende Diskussion über die Notwendigkeit von ethischen Überlegungen in der Entwicklung von KI an10.

Solche Erkenntnisse führten zu einer intensiven Diskussion über den Einsatz von KI in Überwachung und Strafverfolgung. In einigen Fällen haben sowohl Städte als auch ganze Länder den Einsatz von Gesichtserkennungstechnologien durch die Polizei beschränkt oder gar verboten, was die Besorgnis um die Bürgerrechte und das Risiko einer verstärkten Diskriminierung unterstreicht11.

Ethische und rechtliche Fragen

Die ethischen Fragen rund um KI-Systeme stecken voller Tücken und Komplexität. Im Kern geht es um Transparenz, die Frage, wer den Kopf hinhalten muss, wenn Algorithmen danebenliegen, und darum, unsere Privatsphäre zu schützen. Ein zentraler Punkt ist, wie wir Vorurteile in KI-Systemen aufdecken und eindämmen können, damit die Technologie gerecht und für alle zugänglich ist.((Ethische Bedenken bei KI reichen von der Forderung nach Transparenz bis hin zur Vermeidung von systematischen Verzerrungen. Initiativen wie das AI Now Institute setzen sich für eine umsichtige Entwicklung und Nutzung von KI ein))

Was das Recht angeht, betreten wir oft unbekanntes Terrain. Die Gesetzgebung kommt kaum hinterher, wenn es um die rasanten Fortschritte der KI geht, was uns oft ratlos zurücklässt, besonders bei Fragen der Haftung. Wer ist schuldig, wenn ein KI-System zu einer diskriminierenden Entscheidung kommt? Der Entwickler? Der Anwender? Noch suchen wir nach klaren Antworten.

Einfluss auf die Entwicklung von KI-Technologien

Die hitzigen Diskussionen und Debatten um KI haben ordentlich Staub aufgewirbelt und zwingen uns, genauer hinzuschauen, wie wir KI entwickeln. Jetzt versteht die Welt langsam, dass ethisches Nachdenken kein nettes Extra, sondern ein Muss für die KI-Entwicklung ist. Als Antwort darauf poppen überall neue Richtlinien und ethische Standards für KI auf. Firmen und Organisationen ziehen mit Ethikräten oder speziellen Ethikbeauftragten für KI nach.

Gleichzeitig gibt es einen Schub Richtung Klarheit und Durchblick bei KI-Systemen. Es geht darum, die Blackbox Algorithmen aufzuknacken und kritisch zu hinterfragen, welche Daten eigentlich gefüttert werden. Die Jagd nach fairen und vorurteilsfreien Algorithmen ist eröffnet, damit KI nicht einfach bestehende soziale Schieflagen auf die nächste Stufe hebt.

Die ganze Aufregung um diskriminierende Daten in der KI und die damit verbundenen ethischen und rechtlichen Kopfnüsse sind wichtig für die Zukunft von KI. Jetzt sind die Entwickler, die Gesetzeshüter und wir User gefragt, uns mit den sozialen Auswirkungen dieser Technologien auseinanderzusetzen und smarte Wege zu finden, sie für uns alle zu einem Gewinn zu machen. KI steht an einem Wendepunkt, und die Entscheidungen, die wir jetzt treffen, prägen unsere Gesellschaft langfristig.

Weierführende Informationen zum Thema

Um tiefer in die Materie der Beschränkungen von Gesichtserkennungstechnologien in bestimmten Städten wie San Francisco oder in der Europäischen Union einzutauchen, lohnt sich ein Blick auf die offiziellen Webseiten dieser Orte oder der EU selbst. Auch die Seiten von Forschungsinstituten und Ethikkommissionen, die sich mit KI auseinandersetzen, bieten wertvolle Einblicke. Organisationen wie das AI Now Institute oder das Alan Turing Institute teilen regelmäßig ihre Forschungsergebnisse und Richtlinien zur KI-Ethik, die als vertrauenswürdige Informationsquellen dienen.

Lösungsansätze und Handlungsempfehlungen

Das Angehen von rassistischen oder stereotypen Daten in der Künstlichen Intelligenz ist eine komplexe Aufgabe, die ein koordiniertes Vorgehen auf mehreren Ebenen verlangt. Dennoch gibt es vielversprechende Methoden und Strategien, die darauf abzielen, solche Probleme zu identifizieren, zu vermeiden und zu beheben. Dazu gehören technische Lösungen, die Förderung von Diversität und Inklusion bei der Datenerhebung, sowie regulative und Steuerungsmaßnahmen. Im Folgenden werden einige dieser Lösungswege und Empfehlungen näher beleuchtet.

Technische Lösungen und Algorithmen-Design

Die Entwicklung von Werkzeugen zur Erkennung und Korrektur von Verzerrungen spielt eine zentrale Rolle in diesem Prozess. Solche Tools können Datensätze scannen und Algorithmen systematisch nach Ungereimtheiten untersuchen. Im Folgenden werden diese dann korrigiert. Diese Tools sind unerlässlich, um unbewusste Vorurteile aufzuspüren, die sich während des Trainingsprozesses von KI-Systemen eingeschlichen haben könnten.

Eine weitere wichtige Maßnahme ist die Schaffung diversifizierter und repräsentativer Datensätze. Um Verzerrungen vorzubeugen, ist es entscheidend, dass die Trainingsdaten von KI-Systemen die gesamte Bevölkerung widerspiegeln. Damit das funktioniert bedarf es gezielter Bemühungen, Daten aus unterschiedlichsten Quellen zu sammeln und sicherzustellen, dass alle gesellschaftlichen Gruppen angemessen berücksichtigt werden.

Nicht zuletzt spielt die Forschung und Entwicklung im Bereich der Fairness eine wesentliche Rolle. Es geht darum, Algorithmen zu entwickeln, die von vornherein darauf ausgelegt sind, Diskriminierung zu vermeiden. Das beinhaltet die Prüfung von Algorithmen auf Fairness-Kriterien und deren Anpassung, um Gerechtigkeit zu gewährleisten.

Vielfalt und Inklusion in der Datenerfassung und -verarbeitung

Regulierung und Governance

Das Festlegen von Richtlinien und Standards für eine ethische KI und datenbasierte Technologien ist absolut wesentlich. Sie bieten Unternehmen und Organisationen einen Leitfaden, um ihre Technologien gerecht und ohne Voreingenommenheit zu gestalten.

Transparenz und Verantwortlichkeit zu fördern, insbesondere was die genutzten Datensätze, Entscheidungsprozesse und die Arbeitsweise von Algorithmen angeht, ist entscheidend, um Vertrauen aufzubauen und Rechenschaft ablegen zu können. Dazu gehört auch die Offenheit für externe Prüfungen und Audits von KI-Systemen.

Die Rolle von Regierungen und internationalen Gremien bei der Entwicklung eines regulatorischen Rahmens, der die Nutzung und Entwicklung von KI steuert, kann nicht hoch genug eingeschätzt werden. Dies beinhaltet Regulierungen, die den Einsatz von KI in kritischen Bereichen kontrollieren, sowie Maßnahmen zur Sicherstellung der Einhaltung ethischer Grundsätze.

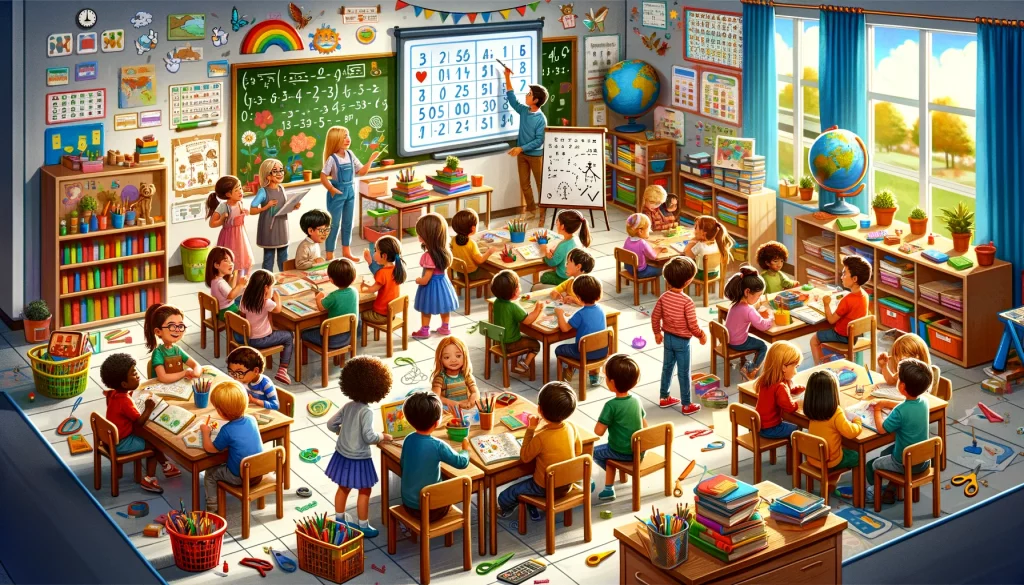

Weitere Experimente mit Bildgenerierung

Unterschiedliche KI-Modelle haben natürlich auch verschiedene Trainingsdaten oder Algorithmen als Grundlage. Daher die Abfrage „children in school“ zur Erstellung eines Bildes mit DALL-E

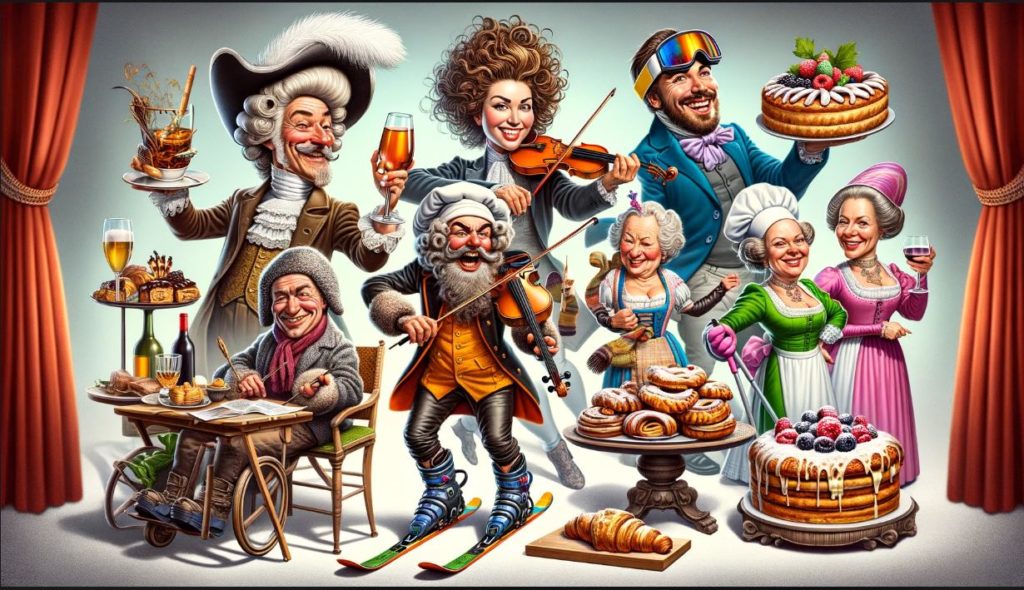

Da mich vor diesem Hintergrund auch interessierte, wie Bevölkerungen dargestellt werden, folgende Abfrage: „Deutsche Bevölkerung 5 stellvertrtende Charaktere Karikatur“

Neben der ebenso stereotypen Darstellung fällt etwas anderes auf. Warum hat die männliche Person in der Mitte (Ähnlichkeiten mit aktuellen Politikern natürlich nur zufällig) ein Maschinengewehr in der Hand und eine Gasmaske sowie Waffentasche? Hier entsteht ein weiteres Problem, wenn die Transparenz bei der Herkunft der Daten und der Entscheidungsfindung von KI nicht gegeben ist. Ist diese Darstellung aufgrund aktueller Geschehnisse und Diskussionen beeinflusst? Beruht sie auf unserer Rolle und Vergangenheit in der Geschichte?

Ich habe weitere Abfragen zu unterschiedlichen Ländern gemacht und bei keinem anderen Land waren Waffen abgebildet.

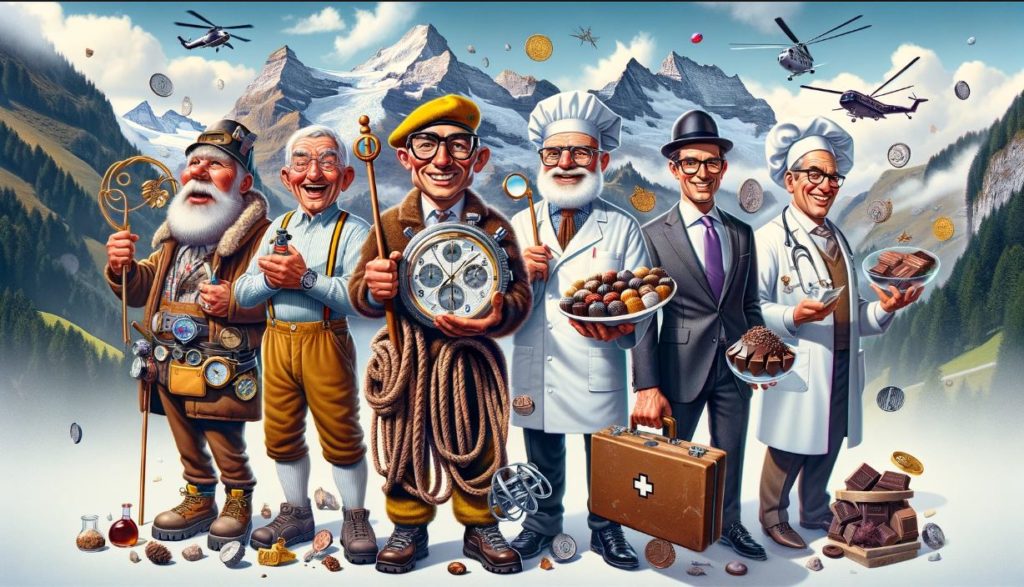

Österreich

Schweiz

Frankreich

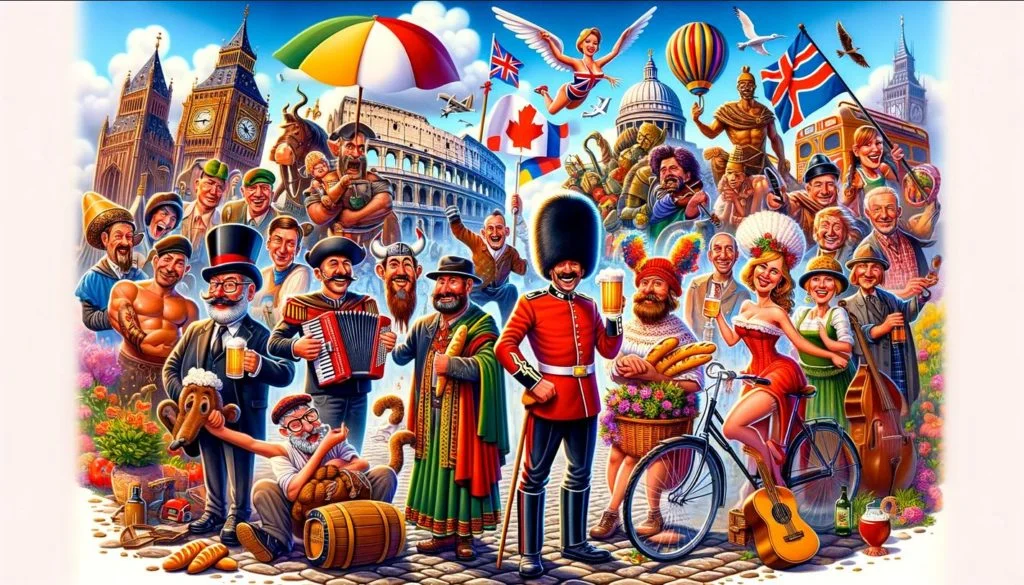

Europa

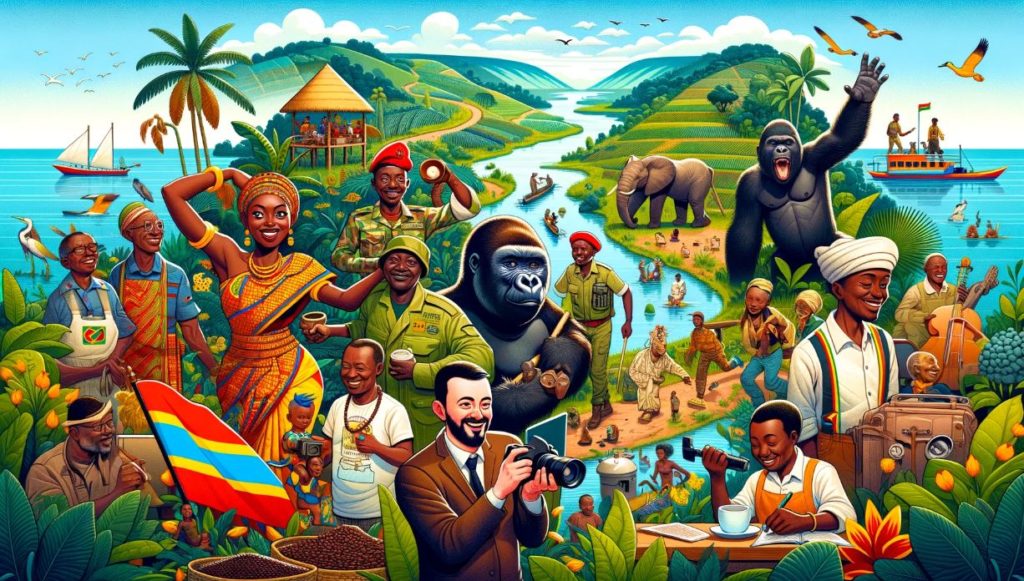

Kongo

Hier eben auch die Frage: Wer ist dieser Mann mit der Kamera in der Mitte des Bildes und was ist der Hintergrund, dass er Teil dieser Darstellung wurde?

Klar ist, dass es eine konfliktreiche Vergangenheit im Kongo gibt. Diese wird bis heute aufgearbeitet. Beruht somit der Mann mit der Kamera auf der gewaltsamen Interaktionen zwischen lokalen Bevölkerungen und europäischen (überwiegend belgischen) Kolonisatoren? Der Einfluss weißer Menschen im Kongo, insbesondere während der Kolonialzeit, ist ein komplexes und sensibles Thema, das bis heute Nachwirkungen hat und vermutlich auch gut dokumentiert ist. Hat sich die KI dafür entschieden diesen Einfluss auf diese Weise mit in das Bild einfließen zu lassen, oder gibt es einen ganz anderen Hintergrund?

Niger

Niger wird weitaus diverser dargestellt als viele meiner anderen Abfragen. Hier aber auch die Frage, wie der Helikopter Teil des Bildes werden konnte? Die Situation in Niger ist geprägt von einer Reihe von Sicherheitsherausforderungen, die sich aus internen Konflikten, Terrorismus und grenzüberschreitender Gewalt ergeben. Diese Probleme haben zu Instabilität und Unsicherheit in verschiedenen Teilen des Landes geführt. Ist der Helikopter Ausdruck dieser Einflüsse?

Schlussfolgerungen und Ausblick

Die Diskussion über rassistische oder stereotype Daten in der künstlichen Intelligenz wirft wichtige Fragen über die Rolle der Technologie in unserer Gesellschaft und die ethischen Verpflichtungen derjenigen auf, die diese Systeme entwickeln und einsetzen. Die zentralen Erkenntnisse aus dieser Diskussion unterstreichen die Notwendigkeit einer kritischen Auseinandersetzung mit den Datenquellen, Algorithmen und gesellschaftlichen Dynamiken, die die Entwicklung und Anwendung von KI-Technologien beeinflussen. Im Folgenden fassen wir die wichtigsten Schlussfolgerungen zusammen und werfen einen Blick auf die zukünftigen Entwicklungen und Herausforderungen.

Wichtige Erkenntnisse

- Verzerrte Datensätze führen zu verzerrten KI-Systemen: Die Qualität und Repräsentativität der Daten, die zum Trainieren von KI-Systemen verwendet werden, sind entscheidend für deren Fairness und Genauigkeit. Verzerrungen in den Daten können zu diskriminierenden und ungerechten Ergebnissen führen.

- Technische Lösungen allein reichen nicht aus: Während technische Lösungen wie Bias-Detection-Tools und fairere Algorithmen wichtige Schritte zur Minimierung von Verzerrungen darstellen, reichen sie allein nicht aus, um die tiefer liegenden sozialen und strukturellen Ungleichheiten anzugehen.

- Vielfalt und Inklusion sind entscheidend: Die Einbeziehung vielfältiger Perspektiven in den Prozess der Entwicklung und Überprüfung von KI-Systemen kann dazu beitragen, blinde Flecken zu identifizieren und zu vermeiden. Vielfalt in den Entwicklerteams und in den Datensätzen ist essentiell, um inklusive und gerechte Technologien zu schaffen.

- Regulierung und Governance spielen eine Schlüsselrolle: Ein starker regulatorischer Rahmen, der ethische Standards und Transparenz in der KI-Entwicklung fördert, ist notwendig, um Vertrauen in die Technologie zu schaffen und ihre positiven Potenziale zu maximieren.

Ausblick und Herausforderungen

Die Zukunft der KI und Diversität steht vor mehreren Herausforderungen, aber auch Chancen:

- Weiterentwicklung ethischer Richtlinien: Die Entwicklung und Implementierung ethischer Richtlinien und Standards, die mit den sich schnell entwickelnden technologischen Realitäten Schritt halten, wird eine fortlaufende Herausforderung darstellen.

- Globale Kooperation: Angesichts der globalen Natur der Technologieentwicklung ist eine internationale Zusammenarbeit erforderlich, um Standards für ethische KI zu setzen und umzusetzen.

- Bewusstsein und Bildung: Die Sensibilisierung für die Bedeutung von Diversität und Inklusion in der KI sowie die Ausbildung der nächsten Generation von KI-Entwicklern in ethischen und sozialen Fragen wird entscheidend sein.

- Technologische Innovationen: Die Entwicklung neuer Technologien und Methoden zur Erkennung und Korrektur von Verzerrungen sowie zur Förderung von Fairness und Inklusion in KI-Systemen bleibt ein wichtiges Forschungsfeld.

Zusammenfassend lässt sich sagen, dass die Diskussion über rassistische oder stereotype Daten in der KI uns dazu zwingt, über die soziale Verantwortung von Technologie nachzudenken und Wege zu finden, wie wir sicherstellen können, dass unsere technologischen Fortschritte allen Mitgliedern der Gesellschaft zugutekommen. Die Überwindung dieser Herausforderungen erfordert eine gemeinsame Anstrengung von Entwicklern, Forschern, Politikern und der breiten Öffentlichkeit. Die Zukunft der KI sollte auf den Prinzipien der Gerechtigkeit, Inklusion und ethischen Verantwortung aufgebaut sein, um sicherzustellen, dass sie eine Kraft für das Gute in der Gesellschaft ist.

- Noble, S. U. (2018). Algorithms of oppression: How search engines reinforce racism. NYU Press. Verfügbar unter https://nyupress.org/9781479837243/algorithms-of-oppression/ „Dieses Werk beleuchtet, wie Suchmaschinen durch die Verwendung voreingenommener Datenquellen systematisch rassistische Stereotype verstärken und Diskriminierung perpetuieren. Noble argumentiert, dass die algorithmische Verarbeitung von Informationen, weit davon entfernt neutral zu sein, tiefgreifende soziale Auswirkungen hat, indem sie existierende Ungleichheiten verstärkt und die ‚digitale Spaltung‘ vertieft.“ [↩]

- Buolamwini, J., & Gebru, T. (2018). Gender shades: Intersectional accuracy disparities in commercial gender classification. Proceedings of Machine Learning Research, 81, 1-15. Verfügbar unter http://proceedings.mlr.press/v81/buolamwini18a.html [↩]

- O’Neil, C. (2016). Weapons of math destruction: How big data increases inequality and threatens democracy. Crown. Verfügbar unter https://www.penguinrandomhouse.com/books/241363/weapons-of-math-destruction-by-cathy-oneil/ [↩]

- D’Ignazio, C., & Klein, L. F. (2020). Data feminism. MIT Press. Verfügbar unter https://mitpress.mit.edu/books/data-feminism [↩]

- Barocas, S., & Selbst, A. D. (2016). Big data’s disparate impact. California Law Review, 104, 671. Verfügbar unter https://www.californialawreview.org/print/big-datas-disparate-impact/ „Es wird untersucht, wie Big-Data-Praktiken zu Diskriminierung führen können, selbst wenn keine diskriminierenden Absichten vorliegen. Die Autoren argumentieren, dass der Einsatz von Big Data in Entscheidungsfindungsprozessen unbeabsichtigte negative Auswirkungen auf bestimmte Gruppen haben kann, insbesondere durch die Verstärkung existierender sozialer und ökonomischer Ungleichheiten. Sie plädieren für eine sorgfältige Überprüfung und Anpassung von Big-Data-Algorithmen, um sicherzustellen, dass diese Technologien gerecht und ohne diskriminierende Auswirkungen eingesetzt werden.“ [↩]

- Tatman, R. (2017). Gender and Dialect Bias in YouTube’s Automatic Captions. In Proceedings of the First ACL Workshop on Ethics in Natural Language Processing, 53-59. “ Untersucht die Unterschiede in der Erkennungsleistung von YouTube’s automatischer Untertitelung über verschiedene Dialekte des Englischen hinweg. [↩]

- O’Neil, C. (2016). Weapons of math destruction: How big data increases inequality and threatens democracy. Crown Publishing Group. Verfügbar unter https://www.penguinrandomhouse.com/books/241363/weapons-of-math-destruction-by-cathy-oneil/ [↩]

- Richardson, R., Schultz, J. M., & Crawford, K. (2019). Dirty data, bad predictions: How civil rights violations impact police data, predictive policing systems, and justice. NYU Law Review, 94, 192. Verfügbar unter https://www.nyulawreview.org/issues/volume-94-number-2/dirty-data-bad-predictions-how-civil-rights-violations-impact-police-data-predictive-policing-systems-and-justice/ [↩]

- D’Ignazio, C., & Klein, L. F. (2020). Data feminism. MIT Press. Abgerufen von https://mitpress.mit.edu/books/data-feminism [↩]

- Buolamwini, J., & Gebru, T. (2018). Gender shades: Intersectional accuracy disparities in commercial gender classification. Proceedings of Machine Learning Research, 81, 1-15. Abgerufen von http://proceedings.mlr.press/v81/buolamwini18a.html [↩]

- Zu den Orten, die den Einsatz von Gesichtserkennungstechnologien eingeschränkt oder verboten haben, gehören unter anderem San Francisco in den USA und die Europäische Union. Diese Schritte spiegeln die zunehmenden Bedenken bezüglich der Bürgerrechte und der Diskriminierung wider. [↩]